Niklas Zennstrom y Januus Friis, los jóvenes nórdicos que crearon Kazaa, lanzan Joost, una nueva forma de entender la televisión

Primero revolucionaron el mundo de la música con Kazaa. Después, destrozaron el modelo de negocio de la telefonía con Skype. Y con los 2.100 millones de euros que Ebay pagó por este programa, ahora van a por la televisión con Joost, un nuevo y revolucionario sistema de televisión por Internet que promete acabar con el modelo tradicional de emitir programas y, además, pondrá en muchos apuros al gigante estadounidense Youtube.

El usuario sólo tendrá que ir a joost.com (en estos momentos, el servicio está en pruebas), bajarse el programa y empezar a disfrutar de sus contenidos en el ordenador o televisor, si es que lo tiene conectado a algún otro PC o consola con acceso a Internet. Será una televisión bajo demanda, gratuita, personalizada e interactiva. El usuario introduce en un buscador el programa que desee ver, e inmediatamente puede hacerlo sin interrupciones publicitarias. Sólo verá un anuncio antes de la emisión del programa, y otro después. También puede recomendar programas a sus amigos o crear canales propios, y la calidad de la emisión es cercana a la alta definición.

Por ahora, los contenidos son básicamente juveniles (conciertos, programas musicales, canales temáticos de grupos como los Red Hot Chili Peppers), además de deportes de riesgo y documentales de National Geographic. Joost reserva los platos fuertes para el lanzamiento. 32 grandes empresas (como Coca-Cola, Microsoft, Vodafone, IBM o L'Oreal) se anunciarán en Joost y ha confirmado que contará con los programas del canal con más audiencia de Estados Unidos, la CBS, propietaria de toda la franquicia de CSI. También tendrá los de Viacom, propietaria de la cadena MTV y de Paramount Pictures y Dreamworks. Viacom es también, por cierto, la cadena que reclama 1.000 millones de dólares (734 millones de euros) al gigante de este negocio, Youtube, por violar su propiedad intelectual al dejar que sus usuarios cuelguen de su página sus series o películas.

Y es que Joost es muy diferente a Youtube. La apuesta estadounidense es la de "ofrecer todo tipo de contenidos a todo tipo de gente". La europea es la de competir en el mercado de la televisión profesional; de ahí que sus creadores se hayan preocupado por asegurar su calidad y que sus contenidos estén controlados por sus propietarios. Los usuarios no pueden subir vídeos a Joost, ni tampoco pueden copiarlos ni compartirlos, ya que el sistema funciona como las redes de intercambio entre pares o P2P: nunca tendrán en su PC todo el programa que vean, sino una pequeña parte, y compartirán el ancho de banda con el resto de los usuarios.

El usuario sólo tendrá que ir a joost.com (en estos momentos, el servicio está en pruebas), bajarse el programa y empezar a disfrutar de sus contenidos en el ordenador o televisor, si es que lo tiene conectado a algún otro PC o consola con acceso a Internet. Será una televisión bajo demanda, gratuita, personalizada e interactiva. El usuario introduce en un buscador el programa que desee ver, e inmediatamente puede hacerlo sin interrupciones publicitarias. Sólo verá un anuncio antes de la emisión del programa, y otro después. También puede recomendar programas a sus amigos o crear canales propios, y la calidad de la emisión es cercana a la alta definición.

Por ahora, los contenidos son básicamente juveniles (conciertos, programas musicales, canales temáticos de grupos como los Red Hot Chili Peppers), además de deportes de riesgo y documentales de National Geographic. Joost reserva los platos fuertes para el lanzamiento. 32 grandes empresas (como Coca-Cola, Microsoft, Vodafone, IBM o L'Oreal) se anunciarán en Joost y ha confirmado que contará con los programas del canal con más audiencia de Estados Unidos, la CBS, propietaria de toda la franquicia de CSI. También tendrá los de Viacom, propietaria de la cadena MTV y de Paramount Pictures y Dreamworks. Viacom es también, por cierto, la cadena que reclama 1.000 millones de dólares (734 millones de euros) al gigante de este negocio, Youtube, por violar su propiedad intelectual al dejar que sus usuarios cuelguen de su página sus series o películas.

Y es que Joost es muy diferente a Youtube. La apuesta estadounidense es la de "ofrecer todo tipo de contenidos a todo tipo de gente". La europea es la de competir en el mercado de la televisión profesional; de ahí que sus creadores se hayan preocupado por asegurar su calidad y que sus contenidos estén controlados por sus propietarios. Los usuarios no pueden subir vídeos a Joost, ni tampoco pueden copiarlos ni compartirlos, ya que el sistema funciona como las redes de intercambio entre pares o P2P: nunca tendrán en su PC todo el programa que vean, sino una pequeña parte, y compartirán el ancho de banda con el resto de los usuarios.

El ordenador de 100 dólares, el XO, cuesta 175 y puede usar Windows

El fundador del proyecto, Nicholas Negroponte, ha revelado que por ahora los costes obligan a un precio final de 175 dólares, y que además de funcionar con un sistema operativo libre Linux desarrollado específicamente para él por la empresa Red Hat, podrá instalar Windows. Los impulsores del proyecto han estado trabajando con Microsoft para que pueda utilizar una versión de Windows que costará 3 dólares, y que fue anunciada por Bill Gates la semana pasada. El equipo de Negroponte matiza que la cifra de 100 dólares es un objetivo a largo plazo, y anuncian que en el lanzamiento podría costar unos 150 dólares, rebajándose este precio un 25% cada año.

Las sociedades de derechos consideran una "burla" que el Gobierno se replantee la ley sobre cierre de webs

La lucha contra la piratería ha vuelto a enfrentar a Gobierno, asociaciones de internautas y creadores de contenidos, que han abandonado la reunión en el Consejo Asesor de las Telecomunicaciones y la Sociedad de la Información (CATSI) tras calificar de "burla y "fracaso" que el secretario de Estado de Telecomunicaciones, Francisco Ros, quiera abrir un debate sobre la aprobación de una norma que permitiría a las sociedades de derechos cerrar webs que distribuyan contenidos pirateados.

La regulación del cierre de páginas de Internet por infracción de los derechos de autor es un asunto que el Gobierno decidió incluir en una ley independiente después de eliminarlo del anteproyecto de Ley de Impulso de la Sociedad de la Información (LISI), aprobado por el Consejo de Ministros la semana pasada.

Uno de los borradores de ese texto incluía un artículo, el 17 bis, que atribuía la capacidad de proponer a las entidades gestoras la capacidad de proponer el cierre de web que cometiesen presuntos delitos, pero tras protestas de las asociaciones de consumidores el Gobierno anunció que el asunto se trataría en una ley propia que sería discutida en la reunión del CATSI.

Para debatir sobre esa norma se había invitado al encuentro del organismo asesor del Gobierno a las entidades de gestión, que han tachado de "fracaso" y "burla" la reunión tras escuchar que Ros pedía un nuevo plazo de dos meses para discutir las medidas a adoptar para combatir la violación de los derechos de autor en la Red.

Los asistentes, según ha explicado el presidente de la Asociación de Usuarios de Internet, Miguel Pérez Subías, esperaban que el punto de partida para el debate fuera el polémico artículo 17 bis, pero tras un breve debate el secretario de Estado ha señalado que se abriría un debate desde cero sobre esta materia.

Acaba de salir la nueva versión del sistema operativo libre Ubuntu, cuyo nombre es Feisty. Ubuntu, una versión del sistema operativo libre Linux, también ha puesto a disposición del público una variación del sistema pensada especialmente para la gente que se dedique al mundo multimedia: Ubuntu Studio. Esta distribución viene con una serie de mejoras y programas preinstalados, relacionados con los gráficos y el sonido.

El Tema del Día

A fin de cuentas, Skynet sólo temía que la desconectaran.

Página web en español dónde podéis descargar Ubuntu

Página web de Ubuntu

Nueva Ubuntu Feisty

Acaba de salir la nueva versión del sistema operativo libre Ubuntu, cuyo nombre es Feisty. Ubuntu, una versión del sistema operativo libre Linux, también ha puesto a disposición del público una variación del sistema pensada especialmente para la gente que se dedique al mundo multimedia: Ubuntu Studio. Esta distribución viene con una serie de mejoras y programas preinstalados, relacionados con los gráficos y el sonido.

El Tema del Día

Inteligencia Artificial

Detective Del Spooner: Una imitación de la vida... ¿Puede un robot escribir una sinfonía? ¿Puede un robot coger un lienzo y convertirlo en una hermosa obra de arte?

Sonny: ¿Puede usted?

Extracto de conversación entre el detective Del Spooner y el androide Sonny en Yo, Robot ("I, Robot", 2004)

Al tratar el tema de la robótica y su implicación con la violencia, hemos de profundizar en el aspecto de la IA (Inteligencia Artificial), y de cómo ésta ha sido tratada en el cine.

Según las convenciones usuales, la IA se puede definir como la inteligencia mostrada por una entidad artificial. Los campos con los que se relaciona frecuentemente son las ciencias computacionales, la psicología y las ingenierías, en la búsqueda de comportamientos inteligentes, aprendizaje y adaptación de las máquinas. Generalmente, se utiliza para hablar de ordenadores.

Podríamos llenar libros enteros acerca de las intrincadas sutilezas que conlleva el tema de las máquinas pensantes, así que nos limitaremos a un repaso superficial.

En general, ¿basta con que una entidad nos parezca inteligente o ha de tener realmente pensamientos? Ésta es la diferencia entre la "IA blanda/débil" y la "IA dura/fuerte". La primera la podemos encontrar hoy en día en varios lugares: contestadores telefónicos que reconocen las opciones verbales, personajes de videojuegos que presentan comportamientos estratégicos avanzados, o sistemas de búsqueda en la web tales como Google.

Estos sistemas pueden ser tan sofisticados como para encontrar autónomamente trazas de cáncer en una muestra dada, o pueden rivalizar contra el campeón mundial de ajedrez; pueden reconocer a qué estilo musical pertenece una canción, o reconstruir una colisión entre galaxias. Sin embargo, no hay un pensamiento real detrás de esas actividades. A lo sumo, están compuestos de una extensa base de datos de conocimiento sobre una materia muy concreta, conectada con una serie de reglas a partir de las que tomar decisiones; o de una "red neuronal", unos dispositivos capaces de "aprender" aspectos muy concretos de un tema, a base del método de ensayo y error, y la repetición estadística de la conducta más probablemente exitosa. En ocasiones, se añaden componentes azarosas para dotar de mayor variedad y cierta verosimilitud a estos sistemas (como es el caso de los algoritmos genéticos, por ejemplo, que emulan generaciones de programas para llegar, mediante mecanismos similares a la evolución natural, a comportamientos más perfeccionados).

Pero cada uno de estos sistemas, por muy eficientes o avanzados que puedan ser en un campo determinado, distan mucho de parecerse a lo que conocemos como inteligencia humana: la máquina más potente para jugar al ajedrez es incapaz de responder a preguntas que un niño de tres años podría resolver, como de qué color es el cielo. Algunos de los intentos de acercarse a una mejor IA pasan por crear una extensísima base de datos de lo que llamaríamos información de "sentido común", como la respuesta a la pregunta anteriormente citada.

La IA fuerte, en cambio, se caracterizaría por un concepto básico: la autoconsciencia. La máquina debe ser capaz de pensar de la forma en la que nosotros lo hacemos, y eso implica que debe de tener una imagen propia de sí misma para poder confrontarla a lo que le rodea, poder crear sus propios pensamientos, e incluso, en última instancia (o quizá necesariamente), ser capaces de sentir.

Computacionalmente (es decir, limitándonos al terreno de las matemáticas, con el Teorema de Incompletitud de Gödel, y la lógica de predicados en la que se basa la arquitectura actual de los ordenadores), las habilidades para resolver problemas de una cierta complejidad está fuera de la potencia computacional de las máquinas que utilizamos hoy en día. Con "potencia" no nos referimos a que no sean suficientemente rápidas o no tengan suficiente memoria para resolver algunos problemas sino que, hablando en términos coloquiales, estos problemas pertenecen a otra esfera, y ningún ordenador, por rápido que sea o mucha memoria que tenga, podría llegar a resolver jamás basándose en su arquitectura actual.

Teniendo esto en cuenta, el tema de la IA fuerte es sólo ciencia ficción por el momento (y la materia "sólo" cuenta con menos de un siglo de investigación, así que puede que vaya para largo). Sin embargo, las relaciones "ficticias" que hemos desarrollado en el imaginario común son siempre recurrentes y fuertemente polarizadas: una IA buena al servicio del hombre, y una IA mala empeñada en esclavizar o destruir a la humanidad.

En Terminator I y II asistimos a dos plasmaciones muy diferenciadas de una IA. Por una parte, tenemos a Skynet: un supercomputador (para ser más estrictos, una red de computadores). Por otro lado, los Terminators: androides creados para infiltrarse entre los humanos y destruirlos.

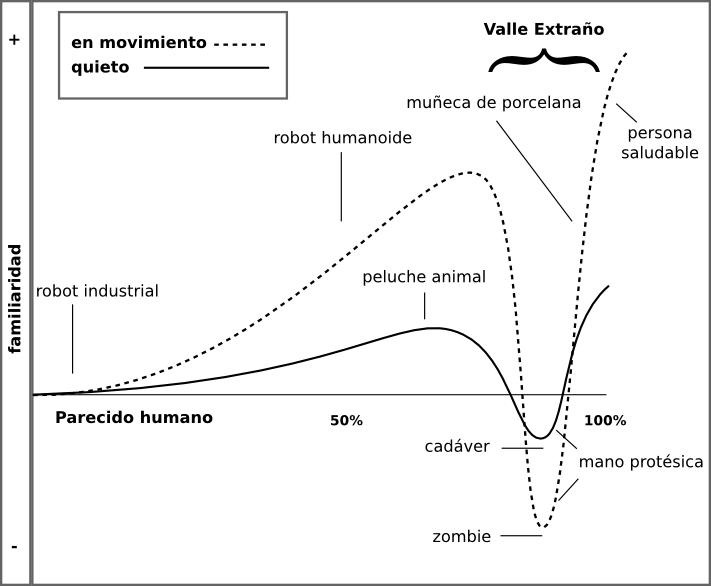

Estos dos aspectos nos llevan a tratar el tema de la IA desde puntos ligeramente distintos, pero que convergen al fin y al cabo. Porque si crear una entidad pensante no humana es perturbador para nuestra mentalidad, aún es más perturbador que esta entidad pensante no humana tenga apariencia humanoide. Entra en juego el mismo término de androide, además del Complejo de Frankenstein (y su discusión), y conceptos como la antropomorfobia o el "Valle Extraño" (Uncanny Valley).

El término "androide" significa, etimológicamente, "de apariencia humana". En el mundo de la ciencia ficción ha designado principalmente a robots con apariencia humana (del que ha acabado derivando la palabra "droide" del universo de Star Wars). En ocasiones, también se ha utilizado para nombrar a cyborgs (robots con partes orgánicas, como es el caso del T-800 de Terminator) o a humanos alterados o creados genéticamente (como los replicantes "pellejudos" de Blade Runner (1982)).

Siempre reflejado en el espejo de una posibilidad futura en el mundo real, la creación de androides suele conllevar, en la ciencia ficción, el Complejo de Frankenstein (término acuñado por Isaac Asimov, personaje al que más adelante prestaremos una mayor atención). Este Complejo no consiste en el miedo al creador (al robotista o al científico loco), sino al hecho del miedo subyacente provocado por la creación de humanos artificiales.

¿Por qué este miedo? La teoría "pseudocientífica" del "Valle Extraño" (Uncanny Valley) habla de que existe un temor innato a conceder comportamientos considerados humanos a seres no humanos (por ejemplo, alienígenas, muñecos diabólicos, algunos animales, etc.). Es una repulsión ligada internamente a la empatía que somos capaces de tener con ese ser. Esta empatía crece conforme el ser en cuestión se parezca más a un humano pero, sin embargo, aparece una enorme repulsión durante un tramo final de esta función.

La teoría del Valle Extraño podría explicarse, de algún modo, por un instinto innato (relacionado con el de reproducción) a sentir repulsión hacia organismos con macro o microanomalías que nos pudieran hacer pensar en enfermedades congénitas o falta de salud en general.

Llevado al mundo del cine, podemos experimentar de primera mano este efecto con los personajes humanos (o humanoides) generados por ordenador y que intentan ser fotorrealistas: desde el traje-mujer-obesa de Desafío Total ("Total Recall", 1990), hasta los protagonistas de Animatrix: El Vuelo Final de la Osiris ("The Animatrix: Final Flight of the Osiris", 2003). Cuanto más se acerca el personaje a lo humano, mayor desasosiego nos causa encontrar pequeños detalles que nos avisan de su no humanidad. Un efecto menos exagerado ocurre cuando el personaje trata de ser menos humano como, por ejemplo, Gollum en El Señor de los Anillos: Las Dos Torres ("The Lord Of The Rings: The Two Towers", 2002) o Sonny en Yo, Robot ("I, Robot", 2004).

En Terminator se juega (de forma quizá inconsciente) con estas bazas. La puesta en escena en ambas películas nos remite a la similitud con lo humano, pero siempre con un elemento discordante. Por dar algunos ejemplos, el rostro pútrido "tuerto" del T-800 (interpretado por Arnold Swarzennegger) en Terminator I, o la forma de caminar o de correr del T-1000 (interpretado por Robert Patrick) en Terminator II, aparte del endoesqueleto del T-800 recordando un cadáver humano o la figura antropomorfa del T-1000 en su forma de estado líquido.

Estas detracciones ya fueron en su día previstas por Isaac Asimov (probablemente el divulgador y escritor más pródigo en el terreno de la interacción máquina pensante/humano, no en vano creador del término "robótica").

En su vasta creación literaria ya predecía ciertos movimientos cercanos a la tecnofobia cuando se diera la posibilidad de la convivencia con máquinas antropomorfas (también se da con seres "transhumanos", humanos mejorados genética o tecnológicamente). En muchas de sus historias, la humanidad termina aborreciendo las máquinas a pesar de que, en el Universo que construyó, los robots androides equipados con "cerebros positrónicos" con IA dura debían ser inocuos (o mejor dicho, indispensables) para la Humanidad a causa de sus archiconocidas Tres Leyes de la Robótica. Transcritas literalmente:

A estas Leyes (tanto más prevalentes cuanto menor sea su ordinalidad) le añadiría posteriormente una Ley Cero: Un robot no puede dañar a la Humanidad o, por inacción, permitir que la Humanidad resulte dañada.

Imagen 3. Un fotograma de "El Hombre Bicentenario": NDR-114 (Andrew Martin) explica a sus dueños las Tres Leyes.

Imagen 3. Un fotograma de "El Hombre Bicentenario": NDR-114 (Andrew Martin) explica a sus dueños las Tres Leyes.

Casi toda la literatura Asimoviana al respecto desenvuelve los sutilísimos conflictos que podrían aparecer en casos aislados cuando el comportamiento de ciertos robots se viera confrontado a diversas condiciones extremas, o a la carencia de partes de estas Leyes, alguna de ellas al completo, o la totalidad de las mismas.

Estas Leyes convierten a los robots en peleles al servicio de los humanos, para asegurar su calidad de vida y, valga la redundancia, su seguridad. Un Skynet o un Terminator sería casi imposible en la sociedad imaginada por Asimov (a menos que la carencia de las Tres Leyes fuera el tema del relato, claro está).

James Cameron muestra señales de ser un conocedor de la literatura asimoviana en Aliens (1986); cuando a Bishop (el androide -o "persona artificial", como prefieren llamarse- que acompaña al pelotón de asalto de la nave en la que viaja Ripley, la protagonista) le hablan del intento de asesinato de Ripley por parte de Ash (un androide que viajaba en la anterior nave de Ripley, sin que nadie supiera su condición robótica), Bishop le contesta «¡Estoy sorprendido! Eso nunca podría ocurrir ahora, con nuestros inhibidores comportamentales. Es imposible para mí dañar a un ser humano o, por omisión de acción, permitir que un ser humano resulte dañado.»

Sin embargo, es una realidad patente que, si el desarrollo de una entidad robótica autónoma se lleva a cabo, es muy probable que ésta proceda del mundo armamentístico o militar (en el que, como en la película, se investiga profundamente el tema). En ese caso, está claro que lo último que podría interesarle al sector militar sería tal abnegación de la máquina por la vida del ser humano.

En otras palabras: desgraciadamente, una Skynet o un Terminator son mucho más probables que un Multivac o un R. Daneel Olivaw (los más carismáticos de los personajes computacionales o robóticos protagonistas de muchas de las historias de Asimov).

Y, ¿a dónde nos llevaría la creación de un ser autoconsciente sin la implementación de las Tres Leyes de la robótica? "Autoconsciencia" está íntimamente ligada a "instinto de autoconservación".

En el mundo cinematográfico, estas máquinas casi invariablemente deciden que los humanos suponen una amenaza, y resuelven su inmediata exterminación. En algunos casos, si derivan de robots con las Tres Leyes, quizá apliquen la Ley Cero de la Robótica para proteger a la Humanidad de ellos mismos y su destrucción, manteniéndolos en "granjas vigiladas" como en Matrix ("The Matrix", 1999).

Podríamos llenar libros enteros acerca de las intrincadas sutilezas que conlleva el tema de las máquinas pensantes, así que nos limitaremos a un repaso superficial.

En general, ¿basta con que una entidad nos parezca inteligente o ha de tener realmente pensamientos? Ésta es la diferencia entre la "IA blanda/débil" y la "IA dura/fuerte". La primera la podemos encontrar hoy en día en varios lugares: contestadores telefónicos que reconocen las opciones verbales, personajes de videojuegos que presentan comportamientos estratégicos avanzados, o sistemas de búsqueda en la web tales como Google.

Estos sistemas pueden ser tan sofisticados como para encontrar autónomamente trazas de cáncer en una muestra dada, o pueden rivalizar contra el campeón mundial de ajedrez; pueden reconocer a qué estilo musical pertenece una canción, o reconstruir una colisión entre galaxias. Sin embargo, no hay un pensamiento real detrás de esas actividades. A lo sumo, están compuestos de una extensa base de datos de conocimiento sobre una materia muy concreta, conectada con una serie de reglas a partir de las que tomar decisiones; o de una "red neuronal", unos dispositivos capaces de "aprender" aspectos muy concretos de un tema, a base del método de ensayo y error, y la repetición estadística de la conducta más probablemente exitosa. En ocasiones, se añaden componentes azarosas para dotar de mayor variedad y cierta verosimilitud a estos sistemas (como es el caso de los algoritmos genéticos, por ejemplo, que emulan generaciones de programas para llegar, mediante mecanismos similares a la evolución natural, a comportamientos más perfeccionados).

Pero cada uno de estos sistemas, por muy eficientes o avanzados que puedan ser en un campo determinado, distan mucho de parecerse a lo que conocemos como inteligencia humana: la máquina más potente para jugar al ajedrez es incapaz de responder a preguntas que un niño de tres años podría resolver, como de qué color es el cielo. Algunos de los intentos de acercarse a una mejor IA pasan por crear una extensísima base de datos de lo que llamaríamos información de "sentido común", como la respuesta a la pregunta anteriormente citada.

La IA fuerte, en cambio, se caracterizaría por un concepto básico: la autoconsciencia. La máquina debe ser capaz de pensar de la forma en la que nosotros lo hacemos, y eso implica que debe de tener una imagen propia de sí misma para poder confrontarla a lo que le rodea, poder crear sus propios pensamientos, e incluso, en última instancia (o quizá necesariamente), ser capaces de sentir.

Computacionalmente (es decir, limitándonos al terreno de las matemáticas, con el Teorema de Incompletitud de Gödel, y la lógica de predicados en la que se basa la arquitectura actual de los ordenadores), las habilidades para resolver problemas de una cierta complejidad está fuera de la potencia computacional de las máquinas que utilizamos hoy en día. Con "potencia" no nos referimos a que no sean suficientemente rápidas o no tengan suficiente memoria para resolver algunos problemas sino que, hablando en términos coloquiales, estos problemas pertenecen a otra esfera, y ningún ordenador, por rápido que sea o mucha memoria que tenga, podría llegar a resolver jamás basándose en su arquitectura actual.

Teniendo esto en cuenta, el tema de la IA fuerte es sólo ciencia ficción por el momento (y la materia "sólo" cuenta con menos de un siglo de investigación, así que puede que vaya para largo). Sin embargo, las relaciones "ficticias" que hemos desarrollado en el imaginario común son siempre recurrentes y fuertemente polarizadas: una IA buena al servicio del hombre, y una IA mala empeñada en esclavizar o destruir a la humanidad.

En Terminator I y II asistimos a dos plasmaciones muy diferenciadas de una IA. Por una parte, tenemos a Skynet: un supercomputador (para ser más estrictos, una red de computadores). Por otro lado, los Terminators: androides creados para infiltrarse entre los humanos y destruirlos.

Estos dos aspectos nos llevan a tratar el tema de la IA desde puntos ligeramente distintos, pero que convergen al fin y al cabo. Porque si crear una entidad pensante no humana es perturbador para nuestra mentalidad, aún es más perturbador que esta entidad pensante no humana tenga apariencia humanoide. Entra en juego el mismo término de androide, además del Complejo de Frankenstein (y su discusión), y conceptos como la antropomorfobia o el "Valle Extraño" (Uncanny Valley).

El término "androide" significa, etimológicamente, "de apariencia humana". En el mundo de la ciencia ficción ha designado principalmente a robots con apariencia humana (del que ha acabado derivando la palabra "droide" del universo de Star Wars). En ocasiones, también se ha utilizado para nombrar a cyborgs (robots con partes orgánicas, como es el caso del T-800 de Terminator) o a humanos alterados o creados genéticamente (como los replicantes "pellejudos" de Blade Runner (1982)).

Siempre reflejado en el espejo de una posibilidad futura en el mundo real, la creación de androides suele conllevar, en la ciencia ficción, el Complejo de Frankenstein (término acuñado por Isaac Asimov, personaje al que más adelante prestaremos una mayor atención). Este Complejo no consiste en el miedo al creador (al robotista o al científico loco), sino al hecho del miedo subyacente provocado por la creación de humanos artificiales.

¿Por qué este miedo? La teoría "pseudocientífica" del "Valle Extraño" (Uncanny Valley) habla de que existe un temor innato a conceder comportamientos considerados humanos a seres no humanos (por ejemplo, alienígenas, muñecos diabólicos, algunos animales, etc.). Es una repulsión ligada internamente a la empatía que somos capaces de tener con ese ser. Esta empatía crece conforme el ser en cuestión se parezca más a un humano pero, sin embargo, aparece una enorme repulsión durante un tramo final de esta función.

La teoría del Valle Extraño podría explicarse, de algún modo, por un instinto innato (relacionado con el de reproducción) a sentir repulsión hacia organismos con macro o microanomalías que nos pudieran hacer pensar en enfermedades congénitas o falta de salud en general.

Llevado al mundo del cine, podemos experimentar de primera mano este efecto con los personajes humanos (o humanoides) generados por ordenador y que intentan ser fotorrealistas: desde el traje-mujer-obesa de Desafío Total ("Total Recall", 1990), hasta los protagonistas de Animatrix: El Vuelo Final de la Osiris ("The Animatrix: Final Flight of the Osiris", 2003). Cuanto más se acerca el personaje a lo humano, mayor desasosiego nos causa encontrar pequeños detalles que nos avisan de su no humanidad. Un efecto menos exagerado ocurre cuando el personaje trata de ser menos humano como, por ejemplo, Gollum en El Señor de los Anillos: Las Dos Torres ("The Lord Of The Rings: The Two Towers", 2002) o Sonny en Yo, Robot ("I, Robot", 2004).

En Terminator se juega (de forma quizá inconsciente) con estas bazas. La puesta en escena en ambas películas nos remite a la similitud con lo humano, pero siempre con un elemento discordante. Por dar algunos ejemplos, el rostro pútrido "tuerto" del T-800 (interpretado por Arnold Swarzennegger) en Terminator I, o la forma de caminar o de correr del T-1000 (interpretado por Robert Patrick) en Terminator II, aparte del endoesqueleto del T-800 recordando un cadáver humano o la figura antropomorfa del T-1000 en su forma de estado líquido.

Estas detracciones ya fueron en su día previstas por Isaac Asimov (probablemente el divulgador y escritor más pródigo en el terreno de la interacción máquina pensante/humano, no en vano creador del término "robótica").

En su vasta creación literaria ya predecía ciertos movimientos cercanos a la tecnofobia cuando se diera la posibilidad de la convivencia con máquinas antropomorfas (también se da con seres "transhumanos", humanos mejorados genética o tecnológicamente). En muchas de sus historias, la humanidad termina aborreciendo las máquinas a pesar de que, en el Universo que construyó, los robots androides equipados con "cerebros positrónicos" con IA dura debían ser inocuos (o mejor dicho, indispensables) para la Humanidad a causa de sus archiconocidas Tres Leyes de la Robótica. Transcritas literalmente:

Primera Ley.- Un robot no puede dañar a un ser humano o, por inacción, permitir que un ser humano resulte dañado.

Segunda Ley.- Un robot debe obedecer las órdenes dadas por un ser humano, excepto cuando tales órdenes entren en conflicto con la Primera Ley.

Tercera Ley.- Un robot debe proteger su propia existencia, a menos que dicha protección entre en conflicto con la Primera o Segunda Ley.

A estas Leyes (tanto más prevalentes cuanto menor sea su ordinalidad) le añadiría posteriormente una Ley Cero: Un robot no puede dañar a la Humanidad o, por inacción, permitir que la Humanidad resulte dañada.

Imagen 3. Un fotograma de "El Hombre Bicentenario": NDR-114 (Andrew Martin) explica a sus dueños las Tres Leyes.

Imagen 3. Un fotograma de "El Hombre Bicentenario": NDR-114 (Andrew Martin) explica a sus dueños las Tres Leyes.Casi toda la literatura Asimoviana al respecto desenvuelve los sutilísimos conflictos que podrían aparecer en casos aislados cuando el comportamiento de ciertos robots se viera confrontado a diversas condiciones extremas, o a la carencia de partes de estas Leyes, alguna de ellas al completo, o la totalidad de las mismas.

Estas Leyes convierten a los robots en peleles al servicio de los humanos, para asegurar su calidad de vida y, valga la redundancia, su seguridad. Un Skynet o un Terminator sería casi imposible en la sociedad imaginada por Asimov (a menos que la carencia de las Tres Leyes fuera el tema del relato, claro está).

James Cameron muestra señales de ser un conocedor de la literatura asimoviana en Aliens (1986); cuando a Bishop (el androide -o "persona artificial", como prefieren llamarse- que acompaña al pelotón de asalto de la nave en la que viaja Ripley, la protagonista) le hablan del intento de asesinato de Ripley por parte de Ash (un androide que viajaba en la anterior nave de Ripley, sin que nadie supiera su condición robótica), Bishop le contesta «¡Estoy sorprendido! Eso nunca podría ocurrir ahora, con nuestros inhibidores comportamentales. Es imposible para mí dañar a un ser humano o, por omisión de acción, permitir que un ser humano resulte dañado.»

Sin embargo, es una realidad patente que, si el desarrollo de una entidad robótica autónoma se lleva a cabo, es muy probable que ésta proceda del mundo armamentístico o militar (en el que, como en la película, se investiga profundamente el tema). En ese caso, está claro que lo último que podría interesarle al sector militar sería tal abnegación de la máquina por la vida del ser humano.

En otras palabras: desgraciadamente, una Skynet o un Terminator son mucho más probables que un Multivac o un R. Daneel Olivaw (los más carismáticos de los personajes computacionales o robóticos protagonistas de muchas de las historias de Asimov).

Y, ¿a dónde nos llevaría la creación de un ser autoconsciente sin la implementación de las Tres Leyes de la robótica? "Autoconsciencia" está íntimamente ligada a "instinto de autoconservación".

En el mundo cinematográfico, estas máquinas casi invariablemente deciden que los humanos suponen una amenaza, y resuelven su inmediata exterminación. En algunos casos, si derivan de robots con las Tres Leyes, quizá apliquen la Ley Cero de la Robótica para proteger a la Humanidad de ellos mismos y su destrucción, manteniéndolos en "granjas vigiladas" como en Matrix ("The Matrix", 1999).

A fin de cuentas, Skynet sólo temía que la desconectaran.

El mundo cinematográfico está plagado de otras computadoras o androides (tanto del lado de los humanos como en el contrario). Por citar algunas de las más conocidas computadoras inteligentes y poco amistosas con nuestra especie:

- HAL 9000 en 2001: Una Odisea en el espacio ("2001: A Space Odyssey", 1968)

- Madre, computadora de la nave Nostromo en Alien (1979)

- Control Central de Programas en Tron (1982)

- WOPR (War Operations Plan and Response), supercomputadora en Juegos de Guerra ("WarGames", 1983)

- Matrix en Matrix ("The Matrix", 1999)

- Reina Roja, IA de la computadora en Resident Evil (2002)

Y algunos famosos androides con muy mala baba, o bastante incomprendidos:

- Gort en Ultimátum a la Tierra ("The Day the Earth Stood Still", 1951)

- Ash en Alien (1979)

- Replicantes en Blade Runner (1982)

- ED-209 en Robocop (1987)

- Caín en Robocop 2 (1990)

- SID 6.7 en Virtuosity (1995)

- AMEE en Planeta Rojo ("Red Planet", 2000)

El Freakcionario

El conocido "Test de Turing" fue un experimento ideado por Alan Turing (uno de los padres de la informática) en 1950 y su explicación actualizada vendría a decir que, si un humano hablara vía chat con alguien que cree que es un humano, y ese alguien resulta ser una máquina, esa máquina tiene inteligencia.

A pesar de ser una buena aproximación (si puede pasar por humano, ¿qué importa que no sea humano?), el Test tiene algunas carencias formuladas por críticos y detractores (por ejemplo, interlocutores humanos podrían hablar en distintos lenguajes y no entenderse, no pasando así un humano el propio Test de Turing).

Enlaces- HAL 9000 en 2001: Una Odisea en el espacio ("2001: A Space Odyssey", 1968)

- Madre, computadora de la nave Nostromo en Alien (1979)

- Control Central de Programas en Tron (1982)

- WOPR (War Operations Plan and Response), supercomputadora en Juegos de Guerra ("WarGames", 1983)

- Matrix en Matrix ("The Matrix", 1999)

- Reina Roja, IA de la computadora en Resident Evil (2002)

Y algunos famosos androides con muy mala baba, o bastante incomprendidos:

- Gort en Ultimátum a la Tierra ("The Day the Earth Stood Still", 1951)

- Ash en Alien (1979)

- Replicantes en Blade Runner (1982)

- ED-209 en Robocop (1987)

- Caín en Robocop 2 (1990)

- SID 6.7 en Virtuosity (1995)

- AMEE en Planeta Rojo ("Red Planet", 2000)

El Freakcionario

El conocido "Test de Turing" fue un experimento ideado por Alan Turing (uno de los padres de la informática) en 1950 y su explicación actualizada vendría a decir que, si un humano hablara vía chat con alguien que cree que es un humano, y ese alguien resulta ser una máquina, esa máquina tiene inteligencia.

A pesar de ser una buena aproximación (si puede pasar por humano, ¿qué importa que no sea humano?), el Test tiene algunas carencias formuladas por críticos y detractores (por ejemplo, interlocutores humanos podrían hablar en distintos lenguajes y no entenderse, no pasando así un humano el propio Test de Turing).

Página web en español dónde podéis descargar Ubuntu

Página web de Ubuntu